> 数据图表你知道1.1.3、Transformer拆解:包括Encoder/Decoder、注意力层、前馈神经网络层

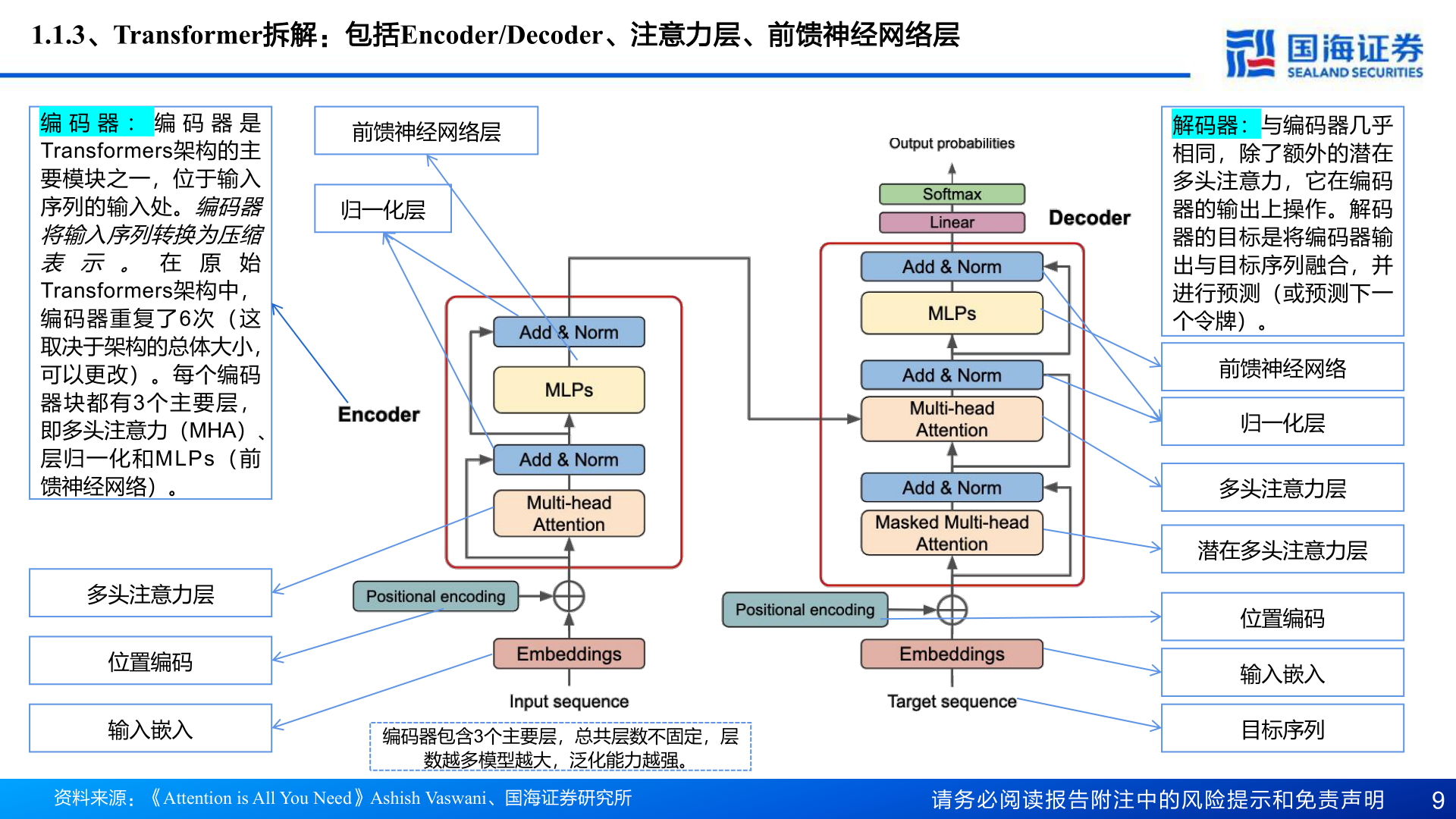

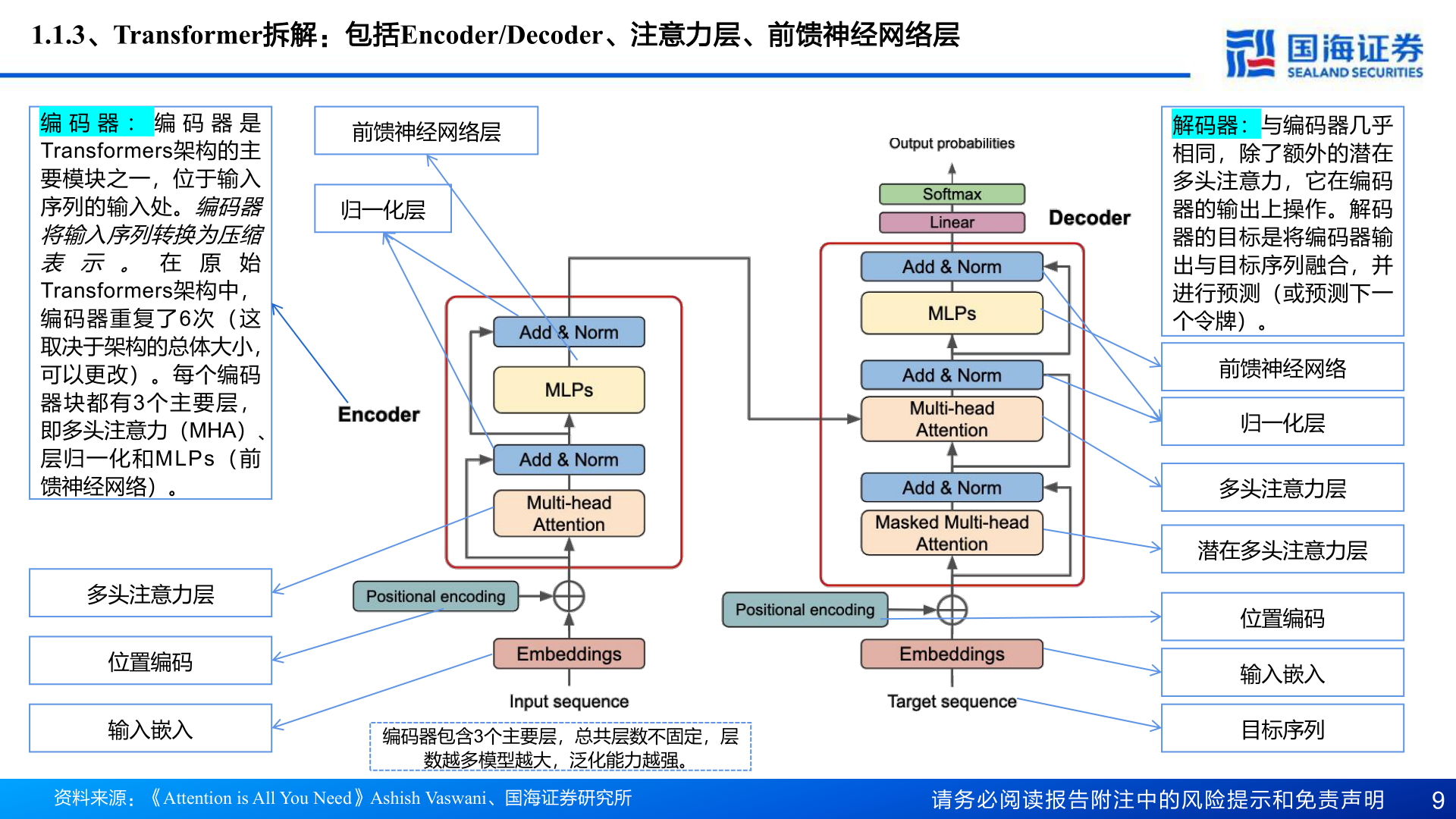

2025-4-11.1.3、Transformer拆解:包括Encoder/Decoder、注意力层、前馈神经网络层编 码 器 : 编 码 器 是Transformers架构的主要模块之一,位于输入序列的输入处。编码器将输入序列转换为压缩表 示 。 在 原 始Transformers架构中,编码器重复了6次(这取决于架构的总体大小,可以更改)。每个编码器块都有3个主要层,即多头注意力(MHA)、层归一化和MLPs(前馈神经网络)。多头注意力层位置编码输入嵌入前馈神经网络层归一化层编码器包含3个主要层,总共层数不固定,层数越多模型越大,泛化能力越强。解码器:与编码器几乎相同,除了额外的潜在多头注意力,它在编码器的输出上操作。解码器的目标是将编码器输出与目标序列融合,并进行预测(或预测下一个令牌)。前馈神经网络归一化层多头注意力层潜在多头注意力层位置编码输入嵌入目标序列资料来源:《Attention is All You Need》Ashish Vaswani、国海证券研究所请务必阅读报告附注中的风险提示和免责声明9