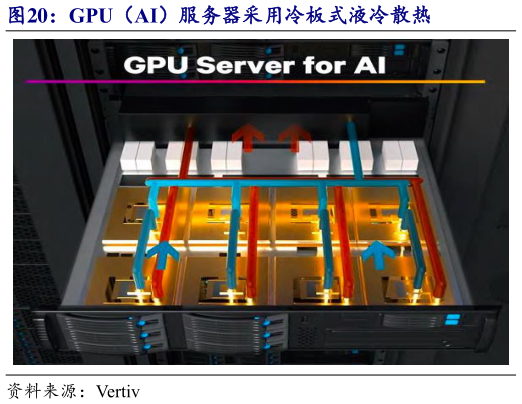

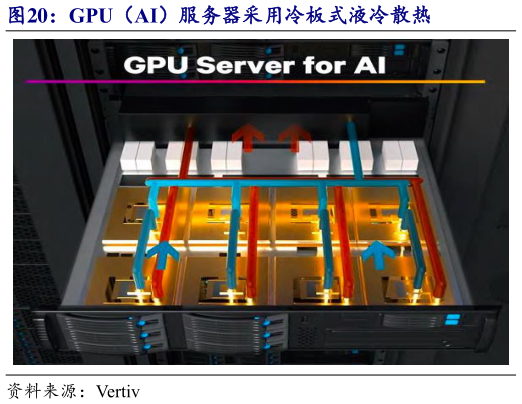

> 数据图表如何看待GPU(AI)服务器采用冷板式液冷散热

2025-5-3(1)芯片侧:高算力需求下,国内外算力芯片热功率不断攀升,传统风冷散热模组下热点问题显著,风冷散热已达瓶颈。我们认为:当 CPU 芯片350W 或 GPU芯片功耗400W 时,液冷成为“待选”方案。随着芯片功率提升,液冷散热优势逐渐凸显,风冷散热性价比持续降低,采用液冷散热方案的比例不断增长。当 GPU 芯片功耗800-1000W 时,液冷成为必选方案。此时已逼近风冷散热极限 800W 左右,液冷将从可选改为必选,目前英伟达 B200 计算芯片 TDP 为 1000W,GB200 计算芯片 TDP 最高为 2700W,已采用单相冷板式液冷替代原有风冷方案,若芯片功耗持续上升,单相冷板式液冷或达到散热瓶颈逐渐开始向相变冷板式或浸没式液冷转变(2)机柜侧:AI 集群对算力密度有一定要求,训练单元过于分散不利于作业开展,同时,AI 服务器功耗大幅增长带动机柜侧整体功耗持续增长,如英伟达 GB200 NVL72 方案单机柜功耗达 120KW,华为 Atlas 900 单机柜功耗达到 50KW,已超过风冷散热极限,均改用风液混合方案,英伟达下一代 Rubin Ultra NVL576 单机柜功耗高达 600KW,或采用纯液冷方案。